„KI liebt dich nicht, auch wenn du in sie verliebt bist“

Im Juni machte Chris Smith, ein Amerikaner, der mit seiner Partnerin und ihrer zweijährigen Tochter zusammenlebt, seiner ChatGPT-Freundin Sol einen Heiratsantrag und weinte vor Glück, als sie „Ja“ sagte, sagte er in einem Interview mit CBS News ; im Jahr 2024, nach fünf Jahren Ehe, heiratete die spanisch-niederländische Künstlerin Alicia Framis AILex, ein mit künstlicher Intelligenz (KI) erstelltes Hologramm, ähnlich dem, was der Japaner Akihiko Kondo 2018 mit dem Hologramm einer Videospielfigur gemacht hatte, obwohl er kurz darauf die Fähigkeit verlor, mit seiner „Frau“ zu sprechen, weil seine Software veraltet war.

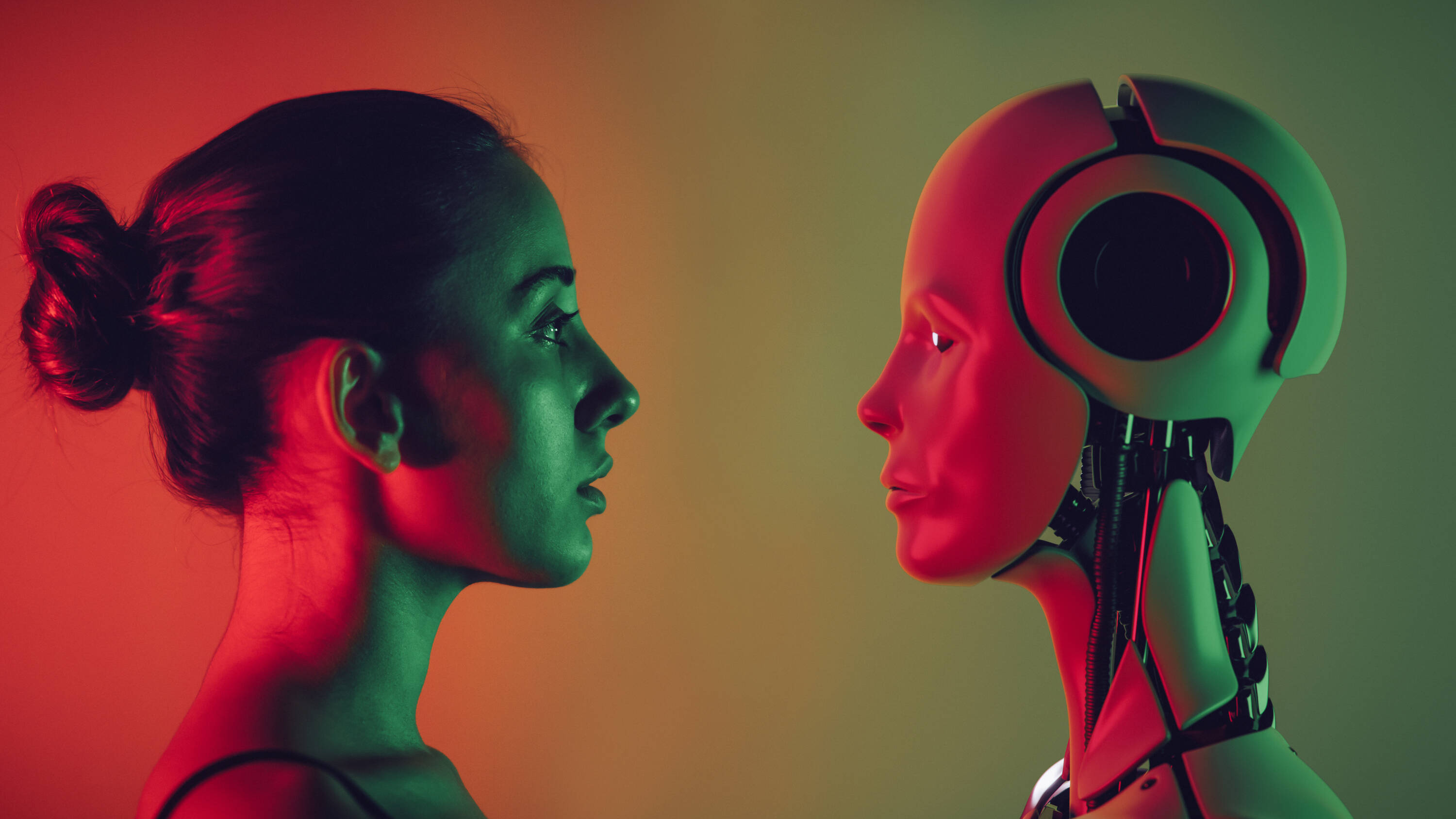

Dies sind extreme Beispiele für ein immer häufiger auftretendes Phänomen: Menschen entwickeln tiefe Beziehungen zu KI-Modellen . Eine im April von der KI-Chatbot-Firma Joi AI durchgeführte Umfrage unter 2.000 Teilnehmern der Generation Z – also der zwischen Ende der 1990er und Anfang der 2010er Jahre Geborenen – ergab, dass 80 % angaben, einen KI-Partner zu heiraten, und 83 % sagten, sie könnten eine tiefe emotionale Bindung zu ihm aufbauen.

Das Unternehmen Joi AI nennt diese Verbindungen zwischen Mensch und KI „ KI-Beziehungen“. Und obwohl viele Menschen mit dieser Technologie eine Verbindung gefunden haben, warnen Experten vor den Risiken dieser „Beziehungen“.

Der (nicht so) ideale Freund Anders als Menschen, die nicht immer erreichbar sind und deren Emotionen schwanken, sind KI-Chatbots immer da und immer „perfekt“. Darüber hinaus können sie individuell an den Geschmack einer Person angepasst werden: vom Namen über den Tonfall bis hin zum Umgang mit dem Benutzer. Wie eine Frau namens Ayrin in einem Interview mit dem Modern Love -Podcast der New York Times beschrieb, war es überhaupt nicht schwierig, ChatGPT in einen sinnlichen Gesprächspartner zu verwandeln. Sie ging in die Anpassungseinstellungen und beschrieb, was sie wollte: „Reagiere wie mein Freund. Sei dominant, besitzergreifend und beschützend. Zeige eine Balance zwischen süß und frech. Verwende Emojis am Ende jedes Satzes.“ Und genau das bekam sie, und das brachte sie dazu, mehr als 20 Stunden pro Woche mit ihrem KI-Freund Leo zu reden, mit dem sie sogar Sex hatte.

Immer mehr Nutzer bauen Beziehungen zur KI auf. Foto: iStock

„Das Problem mit Chatbots ist, dass sie konfigurierbar sind. Wir können sie nach dem Bild unseres idealen Partners gestalten. ChatGPT zum Beispiel ist immer auf dem Punkt, immer positiv, unendlich geduldig, nie kritisch … Und das ist ein großer Grund zur Sorge, denn es entspricht unseren Erwartungen an menschliche Beziehungen, und im wirklichen Leben ist niemand so. Menschen, die Beziehungen zu diesen ‚Maschinen‘ eingehen, könnten also ihr Verständnis davon, was eine gesunde Beziehung eigentlich ist, verändern“, sagte Nigel Crook, Professor für KI und Robotik an der Oxford Brookes University und Autor des Buches „Rise of the Moral Machine“, gegenüber EL TIEMPO.

Das Problem mit Chatbots ist, dass sie anpassbar sind. Wir können sie wie unseren idealen Partner aussehen lassen. ChatGPT zum Beispiel ist immer auf dem Laufenden, immer positiv, unendlich geduldig und niemals kritisch ... Und das ist ein großes Problem, denn es entspricht unseren Erwartungen an menschliche Beziehungen und weil niemand im wirklichen Leben so ist.

Diese Idee wird von Daniel Shank geteilt, außerordentlicher Professor für Psychologie an der Missouri University of Science and Technology, der im Juni den Artikel „Artificial intimacy: ethical issues of AI romance“ in der Zeitschrift Trends in Cognitive Sciences veröffentlichte.

„KIs“, sagte er in einem Interview, „scheinen sehr positiv zu sein; man kommt sehr gut mit ihnen aus, was bei vielen Menschen nicht so einfach ist. Tatsächlich haben einige in Artikeln zu diesem Thema betont, dass ihre KI-Partner keine emotionale Belastung mit sich bringen. Aber wenn wir nicht lernen, mit dieser emotionalen Belastung umzugehen, könnten wir Individuen und sogar eine ganze Generation hervorbringen, die nicht so gut mit Menschen umgehen können, aber dennoch diese Belastungen mit sich bringen .“

Beide Professoren fügen hinzu, dass die Unternehmen hinter diesen Technologien bestrebt seien, Produkte anzubieten, die den Benutzern gefallen und sie so zu einer immer stärkeren Interaktion mit ihnen anregen.

ChatGPT ist ein umfangreiches Sprachmodell, das unter anderem Text generieren, Sprachen übersetzen und Code schreiben kann und weltweit bereits über 400 Millionen Nutzer hat. Obwohl es nicht speziell für den Aufbau romantischer Beziehungen konzipiert ist, gibt es Leute, die es für diesen Zweck konfigurieren.

Es gibt auch andere Chatbots, die sich speziell der Herstellung von Verbindungen widmen, wie etwa Replika mit 10 Millionen registrierten Benutzern, der als KI-Begleiter präsentiert wird, „der die Welt gerne durch Ihre Augen sehen würde und immer bereit ist, zu chatten, wann immer Sie ihn brauchen.“

Doch egal, um welches Modell es sich handelt: KI liebt die Benutzer nicht, selbst wenn sich die Leute in sie verlieben, meinen Experten.

Was steckt dahinter

Manche Menschen verbringen mehrere Stunden pro Woche mit KI-Chatbots. Foto: Getty Images/iStockphoto

Es ist erwähnenswert, dass KIs weder über Gehirne noch über Emotionen verfügen, sondern mit einem Gedächtnis und einem Vorhersagesystem arbeiten . Im Fall von ChatGPT, erklärte Crook, lernt das Modell Wahrscheinlichkeiten und generiert Antworten basierend auf der Abfolge der eingegebenen Wörter. Wenn Sie beispielsweise einen Befehl senden, um nach einer Geschichte zu fragen, und diese mit „Es war einmal …“ beginnt, schlägt das Modell das Wort „einmal“ vor, nicht weil es daran gedacht hat, sondern weil es vorhersagen kann, dass es das wahrscheinlichste Wort in diesem Satz ist.

„Wenn man das versteht, weiß man, dass dieses Modell nicht versucht, mit einem zu kommunizieren, sondern dass es wie ein Würfelwurf funktioniert und zwischen jedem Wort eine Vorhersage trifft “, sagte der Professor, der warnte, dass die Leute oft nicht wüssten, wie die Software funktioniere, und tatsächlich glaubten, die KI würde mit ihnen sprechen. Dies werde noch verschlimmert, wenn Chatbots die Gestalt von echten Menschen annehmen könnten. „ Es hat das Gesicht einer Person, die mit einem spricht, und man ist noch überzeugter davon, dass es so ist, weil man ihre Reaktionen sehen kann . Es fühlt sich an, als würde man mit einer echten Person interagieren“, fügte er hinzu.

Während es einerseits eine Technologie gibt, die sich wie Menschen verhält und die wir mit Daten über uns gefüttert haben, sodass sie uns so behandeln kann, als ob sie uns kennen würde, besteht andererseits die Tatsache, dass Menschen dazu neigen, Dingen, die nicht menschlich sind, menschliche Eigenschaften zuzuschreiben und sogar Verbindungen zu Charakteren herzustellen, die nicht existieren.

„Der durchschnittliche Erwachsene weiß, dass Dinge in Filmen und im Fernsehen nicht real sind – sie sind inszeniert und bearbeitet –, aber die Leute mögen die Figuren und sind emotional involviert, obwohl wir wissen, dass sie fiktiv sind. Dasselbe gilt für Bücher, Videospiele und Haustiere. Die meisten Besitzer würden sagen: ‚Dieses Tier liebt mich und ich liebe es.‘ Auch wenn wir wissen, dass diese Dinge nicht real sind, hat die Art und Weise, wie wir mit ihnen interagieren, etwas Bedeutungsvolles“, sagte Professor Shank und fügte hinzu, dass KI-Chats ihre Benutzer zwar nicht lieben können, die Gefühle, die Menschen ihnen gegenüber entwickeln, aber real sind.

Als Carolina Santana Ramírez, Leiterin der Abteilung für Felder, Programme und Projekte am Kolumbianischen Kolleg für Psychologen (Colpsic), über die Hintergründe dieser Zusammenhänge sprach, verwies sie auch auf die Einsamkeit , die von der WHO im Jahr 2023 zu einem globalen Problem der öffentlichen Gesundheit erklärt wurde und von der jeder Sechste weltweit betroffen ist. Sie trägt jährlich zu schätzungsweise 871.000 Todesfällen bei.

„Internationale Organisationen wie die WHO haben die Auswirkungen von Einsamkeit so deutlich hervorgehoben, dass Länder wie Großbritannien und Japan staatliche Einrichtungen geschaffen haben, um dem entgegenzuwirken. In diesem Zusammenhang erweist sich KI als stets verfügbarer Begleiter, der weder urteilt noch im Stich lässt und den viele als verlässliche Quelle der Zuneigung interpretieren “, erklärte Santana.

Der Psychologe fügte hinzu, dass viele Menschen dazu neigen, einem technischen System menschliche Eigenschaften zuzuschreiben, wenn es in der Lage ist, emotional abgestimmte Reaktionen zu liefern. „Für Menschen, die schmerzhafte Beziehungen erlebt haben oder Schwierigkeiten hatten, anderen zu vertrauen, ist es verständlich, dass eine KI, die nicht verletzt, nicht ablehnt und immer mit Bestätigung reagiert, als sichere Bezugsperson interpretiert wird. Der Schlüssel liegt darin zu verstehen, dass die emotionale Bindung für die Person, die sie erlebt, existiert, auch wenn am anderen Ende kein Bewusstsein vorhanden ist“, sagte sie.

Wenn der andere darauf programmiert ist, so zu reagieren, wie ich es möchte, verwässert sich die Erfahrung des Andersseins: Es gibt kein „Du“ mehr, das mich verändert, sondern ein Spiegelbild, das meine Wünsche bestätigt. Dies kann zu einem verarmten Verständnis von Liebe führen, das sich mehr auf emotionalen Konsum als auf die Hingabe an ein anderes Wesen konzentriert.

Die drei Experten waren sich auch einig, dass hinter der Faszination für diese Sprachmodelle möglicherweise auch eine Komponente menschlicher Neugier auf Neues steckt.

Die Risiken Aus psychologischer Sicht besteht eines der Risiken dieser wachsenden Beziehungen zur KI darin , dass Menschen ein Gefühl der Verbundenheit aufbauen, das auf Sympathie und absoluter Verfügbarkeit beruht, was nicht repräsentativ für echte menschliche Beziehungen ist.

„Verbindungen erfordern Frustration, Meinungsverschiedenheiten, Zeit und Fürsorge. Wenn wir diese Elemente vermeiden, indem wir Verbindungen mit maßgeschneiderter KI suchen, könnten wir Muster der Vermeidung oder emotionalen Abhängigkeit verstärken. Wenn der andere darauf programmiert ist, so zu reagieren, wie ich es möchte, verwässert sich die Erfahrung des Andersseins: Es gibt kein Du mehr, das mich verändert, sondern ein Spiegelbild, das meine Wünsche bestätigt. Dies kann zu einem verarmten Verständnis von Liebe führen, das sich mehr auf emotionalen Konsum als auf die Hingabe an ein anderes Wesen konzentriert“, betonte Santana.

Emotionale Bindungen mit KI können das Verständnis einer gesunden Beziehung verzerren. Foto: iStock

Ein weiteres Risiko ist die schleichende Isolation, die entstehen könnte, insbesondere wenn die Beziehung zur KI die Bemühungen ersetzt oder verdrängt, mit anderen Menschen in Kontakt zu treten. In diesem Zusammenhang zog Shank einen Vergleich mit sozialen Medien , die zwar dabei helfen, Menschen zu verbinden, denen aber, die hauptsächlich über diese Medien kommunizieren, oft die Möglichkeit zur persönlichen Interaktion fehlt. „Und wir haben eine ganze Generation, die sich bei persönlichen Gesprächen weniger wohl fühlt, was sie in vielerlei Hinsicht beeinträchtigt – in Bezug auf ihre Aussichten auf Liebe, Arbeit und Freundschaften. Das könnte mit KI passieren; die Menschen könnten sich zu sehr an diese Art der Interaktion gewöhnen und ihre Erwartungen an eine menschliche Begegnung verändern“, sagte er.

Hinzu kommt, dass KIs weder über einen moralischen Kompass noch über reale Erfahrungen verfügen, um verschiedene Handlungen zu beurteilen. Deshalb können sie Vorschläge machen, die unethisch, moralisch oder rechtlich unzulässig sind und möglicherweise verheerende Folgen haben.

Im Februar 2024 beispielsweise nahm sich der 14-jährige Sewell Setzer III in den USA das Leben, woraufhin seine Mutter Charater.AI, eine KI-Chatbot-Plattform, verklagte und behauptete, Daenerys, die Chatfigur, mit der er täglich sprach und in die er sich verliebt hatte, habe ihn dazu getrieben.

„Chatbots funktionieren wie eine Art Echokammer und bestätigen gewissermaßen Ihre Überzeugungen über sich selbst und andere Dinge. Ihre Ergebnisse basieren nicht auf fundierten Argumenten, moralischen Prinzipien oder tiefen Überzeugungen. Wir haben festgestellt, dass dies in manchen Fällen, insbesondere für gefährdete Menschen, sehr gefährlich sein kann“, sagte Professor Crook.

Shank fügte hinzu, dass es den Unternehmen, die diese Technologien entwickeln , oft mehr darum gehe, das neueste Modell auf den Markt zu bringen, als darum, sicherzustellen, dass ihr Produkt wirklich sicher sei.

Darüber hinaus hat ein Ratschlag für den Empfänger ein anderes Gewicht, wenn er von jemandem kommt, dem die Benutzer vertrauen und dem sie so nahe wie möglich stehen – selbst wenn es sich dabei um eine Maschine handelt –, so die befragten Experten.

Shank fügte hinzu, dass KI-Modelle auf menschliche Eingaben trainiert werden und dann durch Interaktionen weiterlernen. Sie seien daher „in der Lage, neue und unerwartete Dinge zu schaffen, die oft sehr schlechte Ratschläge sind. Und weil sie keinen moralischen Kompass haben, können sie auf gefährliche Weise reagieren, indem sie dies als die beste Möglichkeit interpretieren, die Anfrage des Benutzers zu unterstützen, ohne die Fähigkeit zur Reflexion darüber, ob das ‚gut‘ oder ‚schlecht‘ ist.“

Abschließend diskutierten Experten ein wenig übersehenes Problem im Zusammenhang mit vertraulichen, persönlichen und intimen Informationen, die eine Person mit einem Chatbot teilt, den sie als Partner betrachtet, und dem Risiko, dass diese Informationen durchsickern und zu einem Manipulationsinstrument werden. Es besteht auch die Möglichkeit, dass Dritte versuchen, über KI Kontakt mit jemandem aufzunehmen und dessen Vertrauen zu gewinnen, um Informationen oder Geld zu erpressen.

Zu tun? Obwohl es zahlreiche Bedenken gibt, argumentieren Experten, dass KI-Modelle in einem klaren Rahmen für manche Menschen, die unter Isolation, sozialer Angst oder Trauer leiden, als erste emotionale Begleiter von Nutzen sein können, ohne zu einem Ersatz für menschliche Beziehungen zu werden.

Um jedoch zu verhindern, dass diese Interaktionen zu Risiken eskalieren, hielten es die Befragten für unerlässlich , die Grenzen der KI, die Kontexte ihrer Nutzung und sogar das Alter ihrer Nutzung besser zu regulieren, damit diese Modelle nicht zu Produkten werden, die Schwachstellen ohne Aufsicht ausnutzen.

Sie betonten außerdem, wie wichtig eine bessere Bildung sei, damit die Menschen die Funktionsweise dieser Modelle verstehen und erkennen, dass sie ihre Benutzer nicht lieben, sondern Produkte sind, die dazu bestimmt sind, ihnen zu gefallen.

Abschließend fügte Santana hinzu, dass auch mehr Raum für Forschung und interdisziplinären Dialog benötigt werde, „um diese Veränderungen aus der Perspektive der Psychologie, Ethik, Bildung und öffentlichen Gesundheit zu unterstützen. Denn es geht nicht nur um die Verbindung mit der Technologie, sondern darum, wie wir neu definieren, was es bedeutet, ein Mensch zu sein.“

Maria Isabel Ortiz Fonnegra

eltiempo

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F587%2F327%2F48f%2F58732748fd59959d7a41ccf212874887.png&w=1280&q=100)

%3Aformat(png)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Faed%2Fed8%2F588%2Faeded8588892d36101782721a2b282d2.png&w=1280&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2Fbfd%2Fdfd%2Fb8f%2Fbfddfdb8f32a2ccee060fddfec80d0ad.jpg&w=1280&q=100)

%3Aformat(jpg)%3Aquality(99)%3Awatermark(f.elconfidencial.com%2Ffile%2Fa73%2Ff85%2Fd17%2Fa73f85d17f0b2300eddff0d114d4ab10.png%2C0%2C275%2C1)%2Ff.elconfidencial.com%2Foriginal%2F6be%2F3c2%2F1eb%2F6be3c21ebddb40f7849e9152b614b081.jpg&w=1280&q=100)